На

основании уравнения (3.20) можно показать,

что b

будет несмещенной оценкой

,

если выполняется 4-е условие Гаусса —

Маркова:

![]()

(3.21)

так

как

— константа. Если мы примем сильную форму

4-го условия Гаусса — Маркова и предположим,

что х — неслучайная величина, мы можем

также считать Var(x)

известной константой и, таким образом,

![]()

(3.22)

Далее,

если х — неслучайная величина, то

M{Cov(x,u)}

= 0 и, следовательно, M{b}

=

![]()

Таким

образом,

![]()

— несмещенная оценка

Можно получить тот же результат со

слабой формой 4-го условия Гаусса —

Маркова (которая допускает, что переменная

х имеет случайную ошибку, но предполагает,

что она распределена независимо от u

).

За

исключением того случая, когда случайные

факторы в n

наблюдениях в точности «гасят»

друг друга, что может произойти лишь

при случайном совпадении, b

будет отличаться от

в каждом конкретном эксперименте. Не

будет систематической ошибки, завышающей

или занижающей оценку. То же самое

справедливо и для коэффициента а.

Используем

уравнение (2.15):

![]()

(3.23)

Следовательно,

![]()

(3.24)

Поскольку

у определяется уравнением (3.1),

![]()

(3.25)

так

как M{u}=0,

если выполнено 1-е условие Гаусса —

Маркова. Следовательно

![]()

(3.26)

Подставив

это выражение в (3.24) и воспользовавшись

тем, что

![]()

получим:

![]()

(3.27)

Таким

образом, а

— это несмещенная оценка а при условии

выполнения 1-го и 4-го условий Гаусса —

Маркова. Безусловно, для любой конкретной

выборки фактор случайности приведет к

расхождению оценки и истинного значения.

Рассмотрим

теперь теоретические дисперсии оценок

а и Ь. Они задаются следующими выражениями

(доказательства для эквивалентных

выражений можно найти в работе Дж. Томаса

[Thomas,

1983, section

833]):

![]()

(3.28)

Из

уравнения 3.28 можно сделать три очевидных

заключения. Во-первых, дисперсии а

и b

прямо пропорциональны дисперсии

остаточного члена

![]()

.

Чем

больше фактор случайности, тем хуже

будут оценки при прочих равных условиях.

Это уже было проиллюстрировано в

экспериментах по методу Монте-Карло.

Оценки в серии II

были гораздо более неточными, чем в

серии I,

и это произошло потому, что в каждой

выборке мы удвоили случайный член.

Удвоив u,

мы удвоили его стандартное отклонение

и, следовательно, удвоили стандартные

отклонения a

и b.

Во вторых, чем больше число наблюдений,

тем меньше дисперсионных оценок. Это

также имеет определенный смысл. Чем

большей информацией вы располагаете,

тем более точными, вероятно, будут ваши

оценки. В третьих, чем больше дисперсия

![]()

,

тем меньше будет дисперсия коэффициентов

регрессии. В чем причина этого? Напомним,

что (I)

коэффициенты регрессии вычисляются на

основании предположения, что наблюдаемые

изменения

![]()

происходят вследствие изменений

,

но (2) в действительности они лишь отчасти

вызваны изменениями

,

а отчасти вариациями u.

Чем меньше дисперсия

,

тем больше, вероятно, будет относительное

влияние фактора случайности при

определении отклонений

и тем более вероятно, что регрессионный

анализ может оказаться неверным. В

действительности, как видно из уравнения

(3.28), важное значение имеет не абсолютная,

а относительная величина

![]()

и Var(x).

На

практике мы не можем вычислить

теоретические дисперсии

![]()

или

![]()

,

так как

неизвестно, однако мы можем получить

оценку

на основе остатков. Очевидно, что разброс

остатков относительно линии регрессии

будет отражать неизвестный разброс u

относительно линии

![]()

,

хотя в общем остаток и случайный член

в любом данном наблюдении не равны друг

другу. Следовательно, выборочная

дисперсия остатков Var(е),

которую мы можем измерить, сможет быть

использована для оценки

,

которую мы получить не можем.

Прежде

чем пойти дальше, задайте себе следующий

вопрос: какая прямая будет ближе к

точкам, представляющим собой выборку

наблюдений по

и

,

истинная прямая

или линия регрессии

![]()

?

Ответ будет таков: линия регрессии,

потому что по определению она строится

таким образом, чтобы свести к минимуму

сумму квадратов расстояний между ней

и значениями наблюдений. Следовательно,

разброс остатков у нее меньше, чем

разброс значений u,

и Var(e)

имеет тенденцию занижать оценку

.

Действительно, можно показать, что

математическое ожидание Var(e),

если имеется всего одна независимая

переменная, равно

![]()

.

Однако отсюда следует, что если определить

![]()

как

![]()

,

(3.29)

То

будет представлять собой несмещенную

оценку

.

Таким

образом, несмещенной оценкой параметра

регрессии

![]()

является оценка

![]()

.

(3.30)

Теперь

вспомним следующие определения:

стандартное

отклонение случайной величины

– корень квадратный из теоретической

дисперсии случайной величины; среднее

ожидаемое расстояние между наблюдениями

этой случайной величины и ее математическим

ожиданием,

стандартная

ошибка случайной величины

– оценка стандартного отклонения

случайной величины, полученная по данным

выборки.

Используя

уравнения (3.28) и (3.29), можно получить

оценки теоретических дисперсий для a

и b

и после извлечения квадратного корня

– оценки их стандартных отклонений.

Вместо слишком громоздкого термина

«оценка стандартного отклонения функции

плотности вероятости» коэффицинта

регрессии будем использовать термин

«стандартная ошибка» коэффициента

регрессии, которую в дальнейшем мы будем

обозначать в виде сокрашения «с.о.».

Таким образом, для парного регрессионного

анализа мы имеем:

и

(3.31)

Если

воспользоваться компьютерной программой

оценивания регрессии, то стандартные

ошибки будут подсчитаны автоматически

одновременно с оценками a

и b.

Подводя

итог сказанному о точности коэффициентов

регрессии, акценктируем внимание на

следующих выводах.

1.

Оценка a

для параметра

имеет нормальное распределение с

математическим ожиданием a

и стандартным отклонением

,

оценка b

для параметра

имеет

нормальное распределение с математическим

ожиданием b

и стандартным отклонением

![]()

.

2.

Для улучшения точности оценок по МНК

можно увеличивать количество наблюдений

в выборке n,

увеличивать диапазон наблюдений Var(x)

или уменьшать

,

(например, увеличивать точность

измерений).

3.

Стандартная ошибка оценки a

считается по формуле

а

стандартная ошибка оценки b

считается по формуле

![]()

.

В компьютерных программах именно эти

числа приводятся в круглых скобках под

значениями оценок.

Полученные

соотношения проиллюстрируем экспериментами

по методу Монте-Карло, описанными ранее.

В серии I

u

определялось на основе случайных чисел,

взятых из генеральной совокупности с

нулевым средним и единичной дисперсией

![]()

а x

представлял собой набор чисел от 1 до

20. Можно легко вычислить Var(x),

которая равна 33,25.

Следовательно,

![]()

(3.32)

![]()

.

(3.33)

Таким

образом, истинное стандартное отклонение

для b

равно

![]()

.

Какие же результаты получены вместо

этого компьютером в 10 экспериментах

серии I?

Он должен был вычислить стандартную

ошибку, используя уравнение (3.31).

Результаты этих расчетов для 10

экспериментов представлены в табл. 3.5.

Таблица 3.5

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

22.03.2016179.71 Кб71а1.doc

- #

- #

- #

- #

- #

- #

- #

Когда мы подгоняем регрессионную модель к набору данных, нас часто интересует, насколько хорошо регрессионная модель «подходит» к набору данных. Две метрики, обычно используемые для измерения согласия, включают R -квадрат (R2) и стандартную ошибку регрессии , часто обозначаемую как S.

В этом руководстве объясняется, как интерпретировать стандартную ошибку регрессии (S), а также почему она может предоставить более полезную информацию, чем R 2 .

Стандартная ошибка по сравнению с R-квадратом в регрессии

Предположим, у нас есть простой набор данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их баллы за экзамен:

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

R-квадрат — это доля дисперсии переменной отклика, которая может быть объяснена предикторной переменной. При этом 65,76% дисперсии экзаменационных баллов можно объяснить количеством часов, потраченных на учебу.

Стандартная ошибка регрессии — это среднее расстояние, на которое наблюдаемые значения отклоняются от линии регрессии. В этом случае наблюдаемые значения отклоняются от линии регрессии в среднем на 4,89 единицы.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание, что некоторые наблюдения попадают очень близко к линии регрессии, в то время как другие не так близки. Но в среднем наблюдаемые значения отклоняются от линии регрессии на 4,19 единицы .

Стандартная ошибка регрессии особенно полезна, поскольку ее можно использовать для оценки точности прогнозов. Примерно 95% наблюдений должны находиться в пределах +/- двух стандартных ошибок регрессии, что является быстрым приближением к 95% интервалу прогнозирования.

Если мы заинтересованы в прогнозировании с использованием модели регрессии, стандартная ошибка регрессии может быть более полезной метрикой, чем R-квадрат, потому что она дает нам представление о том, насколько точными будут наши прогнозы в единицах измерения.

Чтобы проиллюстрировать, почему стандартная ошибка регрессии может быть более полезной метрикой для оценки «соответствия» модели, рассмотрим другой пример набора данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их экзаменационная оценка:

Обратите внимание, что это точно такой же набор данных, как и раньше, за исключением того, что все значения s сокращены вдвое.Таким образом, студенты из этого набора данных учились ровно в два раза дольше, чем студенты из предыдущего набора данных, и получили ровно половину экзаменационного балла.

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

Обратите внимание, что R-квадрат 65,76% точно такой же, как и в предыдущем примере.

Однако стандартная ошибка регрессии составляет 2,095 , что ровно вдвое меньше стандартной ошибки регрессии в предыдущем примере.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание на то, что наблюдения располагаются гораздо плотнее вокруг линии регрессии. В среднем наблюдаемые значения отклоняются от линии регрессии на 2,095 единицы .

Таким образом, несмотря на то, что обе модели регрессии имеют R-квадрат 65,76% , мы знаем, что вторая модель будет давать более точные прогнозы, поскольку она имеет более низкую стандартную ошибку регрессии.

Преимущества использования стандартной ошибки

Стандартную ошибку регрессии (S) часто бывает полезнее знать, чем R-квадрат модели, потому что она дает нам фактические единицы измерения. Если мы заинтересованы в использовании регрессионной модели для получения прогнозов, S может очень легко сказать нам, достаточно ли точна модель для прогнозирования.

Например, предположим, что мы хотим создать 95-процентный интервал прогнозирования, в котором мы можем прогнозировать результаты экзаменов с точностью до 6 баллов от фактической оценки.

Наша первая модель имеет R-квадрат 65,76%, но это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. К счастью, мы также знаем, что у первой модели показатель S равен 4,19. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*4,19 = +/- 8,38 единиц, что слишком велико для нашего интервала прогнозирования.

Наша вторая модель также имеет R-квадрат 65,76%, но опять же это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. Однако мы знаем, что вторая модель имеет S 2,095. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*2,095= +/- 4,19 единиц, что меньше 6 и, следовательно, будет достаточно точным для использования для создания интервалов прогнозирования.

Дальнейшее чтение

Введение в простую линейную регрессию

Что такое хорошее значение R-квадрата?

Дисперсии и стандартные ошибки коэффициентов

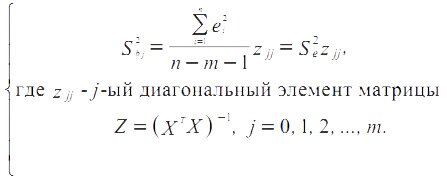

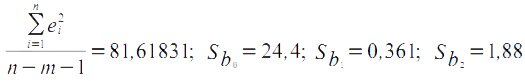

Знание дисперсий и стандартных ошибок в моделях множественной регрессии позволяет анализировать точность оценок, строить доверительные интервалы для теоретических коэффициентов уравнений, проверять соответствующие гипотезы. Выборочные дисперсии эмпирических коэффициентов регрессии имеют вид:

Отметим, что здесь в матрицах (XTX) и (XTX)-1 первая строка и столбец обозначены цифрой 0.

В примере по нахождению коэффициентов множественной линейной регрессии

z00 = 7,310816; z11 = 0,001593; z22 = 0,043213

Как и в случае парной регрессии, Sbj = √Sbj называется стандартной ошибкой коэффициента регрессии.

Отметим, что рассмотренная выше парная линейная регрессия также может быть изложена в матричном виде.

Материалы сайта

Обращаем Ваше внимание на то, что все материалы опубликованы для образовательных целей.

Рассмотрим использование

MS

EXCEL

для прогнозирования переменной

Y

на основании нескольких переменных Х, т.е. множественную регрессию.

Перед прочтением этой статьи рекомендуется освежить в памяти

простую линейную регрессию

– прогнозирование на основе значений только одного фактора.

Disclaimer

: Данную статью не стоит рассматривать, как пересказ главы из учебника по статистике. Статья не обладает ни полнотой, ни строгостью изложения положений статистической науки. Эта статья – о применении MS EXCEL для целей

Множественного регрессионного анализа.

Теоретические отступления приведены лишь из соображения логики изложения. Использование данной статьи для изучения

Регрессии

– плохая идея.

Статья про

Множественный регрессионный анализ

получилась большая, поэтому ниже для удобства приведены ее разделы:

- Оценка неизвестных параметров

- Диаграмма рассеяния

- Вычисление прогнозных значений Y

(отдельное наблюдение и среднее значение) и построение доверительных интервалов

- Стандартные ошибки и доверительные интервалы для коэффициентов регрессии

- Проверка гипотез

- Генерация данных для множественной регрессии с помощью заданного тренда

- Коэффициент детерминации

Прогнозирование единственной переменной Y на основании значений 2-х или более переменных Х называется

множественной регрессией

.

Множественная линейная регрессионная модель

(Multiple Linear Regression Model)

имеет вид Y=β

0

+β

1

*X

1

+β

2

*X

2

+…+β

k

*X

k

+ε. В этом случае переменная Y зависит от k поясняющих переменных Х, т.е.

регрессоров

. ε —

случайная ошибка

. Модель является линейной относительно неизвестных параметров β.

Оценка неизвестных параметров

В этой статье рассмотрим модель с 2-мя регрессорами. Сначала введем необходимые обозначения и понятия множественной регрессии.

Для описания зависимости Y от 2-х переменных

линейная модель

имеет вид:

Y=β

0

+β

1

*X

1

+β

2

*X

2

+ε.

Параметры этой модели β

i

нам неизвестны, но их можно оценить, используя случайную выборку (измеренные значения переменной Y от заданных Х). Оценки параметров модели (β

0

, β

1

, β

2

) обычно вычисляются

методом наименьших квадратов (МНК)

, который минимизирует сумму квадратов ошибок прогнозирования (критерий минимизации в англоязычной литературе обозначают как SSE – Sum of Squared Errors).

Соответствующие оценки параметров будем обозначать как

b

0

,

b

1

и

b

2

.

Ошибка ε имеет случайную природу и имеет свою функцию распределения со

средним значением

=0 и

дисперсией σ

2

.

Оценки

b

1

и

b

2

называются

коэффициентами регрессии

, они определяют влияние соответствующей переменной X, когда все остальные независимые переменные остаются

неизменными

.

Сдвиг (intercept)

или

постоянный

член

b

0

, определяет прогнозируемое значение Y, когда все поясняющие переменные Х равны 0 (часто

сдвиг

не имеет физического смысла в рамках модели и обусловлен лишь математическими вычислениями

МНК

).

Вычислив оценки, полученные методом

МНК,

позволяют прогнозировать значения переменной Y:

Y=

b

0

+

b

1

*X

1

+

b

2

*X

2

Примечание

: Для случая 2-х регрессоров, все спрогнозированные значения переменной Y будут лежать в плоскости (в

плоскости регрессии

).

В качестве примера рассмотрим технологический процесс изготовления нити:

Инженер, на основе имеющегося опыта, предположил, что

прочность нити

Y зависит от

концентрации исходного раствора

(Х

1

) и

температуры реакции

(Х

2

), и соответствует модели линейной регрессии. Для нахождения комбинации переменных Х, при которых Y принимает максимальное значение, необходимо определить коэффициенты регрессии, сделав выборку.

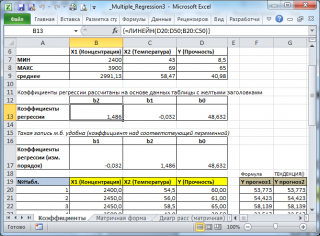

В MS EXCEL

коэффициенты множественной регрессии

удобнее всего вычислить с помощью функции

ЛИНЕЙН()

. Это сделано в

файле примера на листе Коэффициенты

. Чтобы вычислить оценки:

- выделите 3 ячейки в одной строке (т.к. мы рассматриваем случай 2-х регрессоров, то будут вычислены 2

коэффициента регрессии

+

величина сдвига

= 3 значения, для вывода которых понадобится 3 ячейки). Пусть это будет диапазон

С8:Е8

; - в

Строке формул

введите =

ЛИНЕЙН(D20:D50;B20:C50)

. Предполагается, что в столбце

В

содержатся прогнозируемые значения Y (в нашей модели это Прочность нити), в столбцах

С

и

D

содержатся значения контролируемых параметров Х (Х1 – Концентрация в столбце С и Х2 – Температура в столбце D). - нажмите

CTRL

+

SHIFT

+

ENTER

(т.к. этоформула массива

).

В левой ячейке будет рассчитано значение

коэффициента регрессии

b

2

для переменной Х2, в средней ячейке — значение

коэффициента регрессии

b

1

для переменной Х1, в правой –

сдвиг

. Обратите внимание, что порядок вывода

коэффициентов

регрессии

обратный по отношению к расположению столбцов с данными соответствующих переменных Х (вычисленный коэффициент

b

2

располагается

левее

по отношению к

b

1

, тогда как значения переменной Х2 располагаются

правее

значений переменной Х1). Это может привести к путанице, поэтому лучше разместить коэффициенты над соответствующими столбцами с данными, как это сделано в строке 17

файла примера

.

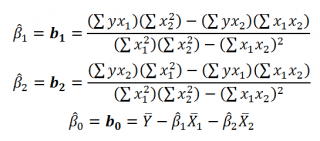

Примечание

: В принципе без функции

ЛИНЕЙН()

можно обойтись, записав альтернативные формулы. Для этого в

файле примера на листе Коэффициенты

в столбцах

I

:

K

вычислены отклонения значений переменных Х

1i

, Х

2i

, Y

i

от их средних значений

![]()

, т.е.:

![]()

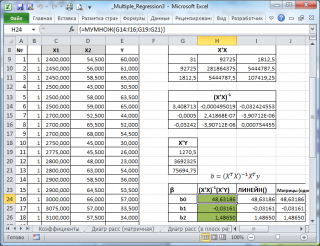

Далее коэффициенты регрессии рассчитываются по следующим формулам (эти формулы справедливы только при прогнозировании по 2-м независимым переменным Х):

При прогнозировании по 3-м и более независимым переменным Х формулы для вычисления

коэффициентов регрессии

значительно усложняются, поэтому следует использовать матричный подход.

В

файле примера на листе Матричная форма

выполнены расчеты

коэффициентов регрессии

с помощью матричного подхода.

Расчет можно произвести как пошагово, так и одной

формулой массива

:

=МУМНОЖ(МОБР(МУМНОЖ(ТРАНСП(B9:D33);(B9:D33)));МУМНОЖ(ТРАНСП(B9:D33);(E9:E33)))

Коэффициенты регрессии

(вектор

b

)

в этом случае вычисляются по формуле

b

=(X

T

X)

-1

(X

T

Y) или в другом виде записи

b

=(X

’

X)

-1

(X

’

Y)

Под Х подразумевается матрица, состоящая из столбцов значений переменной Х с дополнительным столбцом единиц, а под Y – вектор-столбец значений Y.

Символ

Т

или ‘ – это

транспонирование матрицы

, а обозначение

-1

говорит о

вычислении обратной матрицы

.

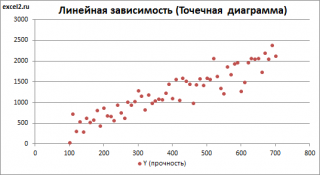

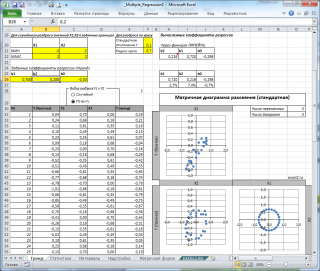

Диаграмма рассеяния

В случае

простой линейной регрессии

(один регрессор, т.е. одна переменная Х) для визуализации связи между прогнозируемым значением Y и переменной Х строят

диаграмму рассеяния

(двумерную).

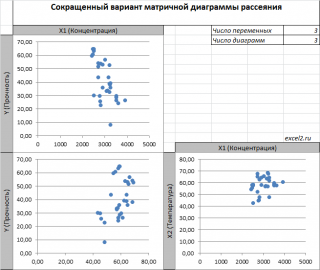

В случае

множественной

линейной регрессии

двумерную диаграмму рассеяния можно построить только для анализа влияния каждого отдельного регрессора на Y (при этом остальные Х не меняются), т.е. так называемую Матричную диаграмму рассеивания (См.

файл примера лист Диагр расс (матричная)

).

К сожалению, такую диаграмму трудно интерпретировать.

Более того, матричная диаграмма может вводить в заблуждение (см.

Introduction

to

linear

regression

analysis

/

D

.

C

.

Montgomery

,

E

.

A

.

Peck

,

G

.

G

.

Vining

, раздел 3.2.5

), демонстрируя наличие или отсутствие линейной взаимосвязи между отдельным регрессором X

i

и Y.

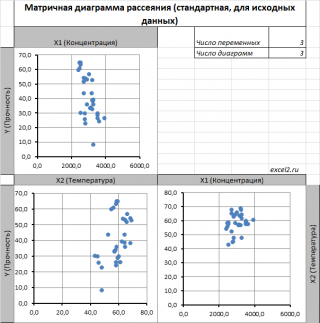

Для случая с 2-мя регрессорами можно предложить альтернативный вид матричной

диаграммы рассеяния

. В стандартной диаграмме рассеяния строятся проекции на координатные плоскости Х1;Х2, Y;X1 и Y;X2. Однако, если взглянуть на точки относительно

плоскости регрессии

, то картину, на мой взгляд, будет проще интерпретировать.

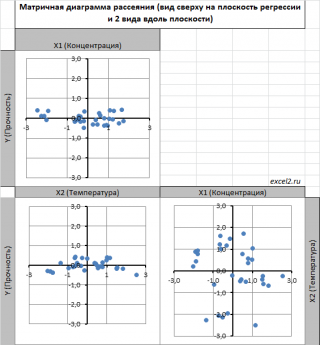

Сравним две матричные диаграммы рассеяния (см.

файл примера на листе «Диагр расс (в плоск регрессии)»

, построенные для одних и тех же наблюдений. Первая – стандартная,

вторая представляет собой вид сверху на плоскость регрессии и 2 вида вдоль плоскости.

На второй диаграмме становится очевидно, что разброс точек относительно плоскости регрессии совсем не большой и поэтому, скорее всего, построенная модель является полезной, а выбранные 2 переменные Х позволяют прогнозировать Y (конечно, для подтверждения этой гипотезы нужно

провести процедуру F-теста

).

Несколько слов о построении альтернативной матричной диаграммы рассеяния:

- Перед построением необходимо нормировать значения наблюдений (для каждой переменной вычесть

среднее

и разделить на

стандартное отклонение

). В этом случае практически все точки на диаграммах будут находится в диапазоне +/-3 (по аналогии со

стандартным нормальным распределением

, 99% значений которого лежат в пределах +/-3 сигма). В этом случае, на диаграмме можно фиксировать мин/макс значений осей, чтобы EXCEL автоматически не модифицировал масштаб осей при изменении данных (это не всегда удобно);

- Теперь координаты точек необходимо рассчитать в системе отсчета относительно плоскости регрессии (в которой плоскость Оху’ совпадает с плоскостью регрессии). Для этого необходимо найти

матрицу вращения

, например, через вращение приводящее к совмещению нормали к плоскости регрессии и вектора оси Z (0;0;1);

- Новые координаты позволяют построить альтернативную матричную диаграмму. Кроме того, для удобства можно вращать систему координат вокруг новой оси Z, чтобы нагляднее представить себе распределение точек относительно плоскости регрессии (для этого использована Полоса прокрутки в ячейках

Q

31:

S

31

).

Вычисление прогнозных значений Y (отдельное наблюдение и среднее значение) и построение доверительных интервалов

После того, как нами были найдены тем или иным способом коэффициенты регрессии можно приступать к вычислению прогнозных значений Y на основе заданных значений переменных Х.

Уравнение прогнозирования или уравнение регрессии в случае 2-х независимых переменных (регрессоров) записывается в виде:

Y=

b

0

+

b

1

*

Х

1

+

b

2

*

Х

2

Примечание:

В MS EXCEL

прогнозное значение Y для заданных Х

1

и Х

2

можно также предсказать с помощью функции

ТЕНДЕНЦИЯ()

. При этом 2-й аргумент будет ссылкой на столбцы, содержащие все значения переменных Х

1

и Х

2

, а 3-й аргумент функции должен быть ссылкой на диапазон ячеек, содержащий 2 значения Х (Х

1i

и Х

2i

) для выбранного наблюдения i (см.

файл примера, лист Коэффициенты, столбец G

). Функция

ПРЕДСКАЗ()

, использованная нами в простой регрессии, не работает в случае

множественной регрессии

.

Найдя прогнозное значение Y, мы, таким образом, вычислим его точечную оценку. Понятно, что фактическое значение Y, полученное при наблюдении, будет, скорее всего, отличаться от этой оценки. Чтобы ответить на вопрос о том, на сколько хорошо мы можем предсказывать новые значения Y, нам потребуется построить

доверительный интервал

этой оценки, т.е. диапазон в котором с определенной заданной вероятностью, скажем 95%, мы ожидаем новое значение Y.

Доверительные интервалы

построим при фиксированном Х для:

- нового наблюдения Y;

- среднего значения Y (интервал будет уже, чем для отдельного нового наблюдения)

Как и в случае

простой линейной регрессии

, для построения

доверительных интервалов

нам потребуется сначала вычислить

стандартную ошибку модели

(standard error of the model)

, которая приблизительно показывает насколько велика ошибка предсказания значений переменной Y на основании значений переменных Х.

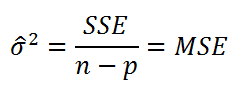

Для вычисления

стандартной ошибки

оценивают

дисперсию

ошибки ε, т.е. сигма^2

(ее часто обозначают как

MS

Е либо

MSres

)

. Затем, вычислив из полученной оценки квадратный корень, получим

Стандартную ошибку регрессии (часто обозначают как

SEy

или

sey

).

где SSE – сумма квадратов значений ошибок модели ei=yi — ŷi (

Sum of Squared Errors

). MSE означает Mean Square of Errors (среднее квадратов ошибок, точнее остатков).

Величина n-p – это количество

степеней свободы

(

df

–

degrees

of

freedom

), т.е. число параметров системы, которые могут изменяться независимо (вспомним, что у нас в этом примере есть n независимых наблюдений переменной Y, р – количество оцениваемых параметров модели). В случае

простой множественной регрессии

с 2-мя регрессорами

число степеней свободы

равно n-3, т.к. при построении

плоскости регрессии

было оценено 3 параметра модели

b

(т.е. на это было «потрачено» 3

степени свободы

).

В MS EXCEL

стандартную ошибку

SEy можно вычислить формулы (см.

файл примера, лист Статистика

):

=

ИНДЕКС(ЛИНЕЙН($E$13:$E$43;$C$13:$D$43;;ИСТИНА);3;2)

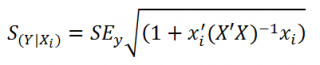

Стандартная ошибка

нового наблюдения Y при заданных значениях Х (вектор Хi) вычисляется по формуле:

x

i

— вектор-столбец со значениями переменных Х (с дополнительной 1) для заданного наблюдения i.

Соответствующий доверительный интервал вычисляется по формуле:

![]()

где α (альфа) –

уровень значимости

(обычно принимают равным 0,05=5%)

р – количество оцениваемых параметров модели (в нашем случае = 3)

n-p – число степеней свободы

–

квантиль

распределения Стьюдента

(задает количество

стандартных ошибок

, в +/- диапазоне которых вероятность обнаружить новое наблюдение равно 1-альфа). Т.е. если

квантиль

равен 2, то диапазон шириной +/- 2

стандартных ошибок

относительно прогнозного значения Y будет с вероятностью 95% содержать новое наблюдение Y (для каждого заданного Хi). В MS EXCEL вычисления квантиля производят по формуле =

СТЬЮДЕНТ.ОБР.2Х(0,05;n-p)

, подробнее см.

в статье про распределение Стьюдента

.

![]()

– прогнозное значение Yi вычисляемое по формуле Yi=

b

0+

b

1*

Х1i+

b

2*

Х2i (точечная оценка).

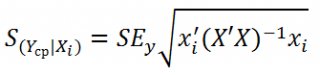

Стандартная ошибка

среднего значения Y при заданных значениях Х (вектор Хi) будет меньше, чем стандартная ошибка отдельного наблюдения. Вычисления производятся по формуле:

x

i

— вектор-столбец со значениями переменных Х (с дополнительной 1) для заданного наблюдения i.

Соответствующий

доверительный интервал

вычисляется по формуле:

![]()

Прогнозное значение Yi (точечная оценка) используется тоже, что и для отдельного наблюдения.

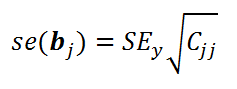

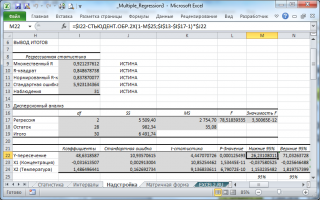

Стандартные ошибки и доверительные интервалы для коэффициентов регрессии

В разделе

Оценка неизвестных параметров

мы получили точечные оценки

коэффициентов регрессии

. Так как эти оценки получены на основе случайных величин (значений переменных Х и Y), то эти оценки сами являются случайными величинами и соответственно имеют функцию распределения со

средним значением

и

дисперсией

. Но, чтобы перейти от

точечных оценок

к

интервальным

, необходимо вычислить соответствующие

стандартные ошибки

(т.е.

стандартные отклонения

)

коэффициентов регрессии

.

Стандартная ошибка коэффициента регрессии

b

j

(обозначается

se

(

b

j

)

) вычисляется на основании

стандартной ошибки

по следующей формуле:

где C

jj

является диагональным элементом матрицы (X

’

X)

-1

. Для коэффициента сдвига

b

0

индекс j=1 (верхний левый элемент), для

b

1

индекс j=2,

b

2

индекс j=3 (нижний правый элемент).

SEy –

стандартная ошибка регрессии

(см.

выше

).

В MS EXCEL

стандартные ошибки коэффициентов регрессии

можно вычислить с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН($E$13:$E$43;$C$13:$D$43;;ИСТИНА);2;j)

Примечание

: Подробнее о функции

ЛИНЕЙН()

см. статью

Функция MS EXCEL ЛИНЕЙН()

.

Применяя матричный подход

стандартные ошибки

можно вычислить и через обычные формулы (точнее через

формулу массива

, см.

файл примера лист Статистика

):

=

КОРЕНЬ(СУММКВРАЗН(E13:E43;F13:F43) /(n-p)) *КОРЕНЬ (ИНДЕКС (МОБР (МУМНОЖ(ТРАНСП(B13:D43);(B13:D43)));j;j))

При построении

двухстороннего доверительного интервала

для

коэффициента регрессии

его границы определяются следующим образом:

b

j

+/- t*Se(

b

j

)

где t – это

t-значение

, которое можно вычислить с помощью формулы =

СТЬЮДЕНТ.ОБР.2Х(0,05;n-p)

для

уровня значимости

0,05.

В результате получим, что найденный

доверительный интервал

с вероятностью 95% (1-0,05) накроет истинное значение

коэффициента регрессии

b

j

.

Здесь мы считаем, что

коэффициент регрессии

b

j

имеет

распределение Стьюдента

с n-p

степенями свободы

(n – количество наблюдений, т.е. пар Х и Y).

Проверка гипотез

Когда мы строим модель, мы предполагаем, что между Y и переменными X существует линейная взаимосвязь. Однако, как это иногда бывает в статистике, можно вычислять параметры связи даже тогда, когда в действительности она не существует, и обусловлена лишь случайностью.

Единственный вариант, когда Y не зависит X, возможен, когда все

коэффициенты регрессии

β

равны 0.

Чтобы убедиться, что вычисленная нами оценка

коэффициентов регрессии

не обусловлена лишь случайностью (они не случайно отличны от 0), используют

проверку гипотез

. В качестве

нулевой гипотезы

Н

0

принимают, что линейной связи нет, т.е. ВСЕ β=0. В качестве альтернативной гипотезы

Н

1

принимают, что ХОТЯ БЫ ОДИН коэффициент β <>0.

Процедура проверки значимости множественной регрессии, приведенная ниже, является обобщением

дисперсионного анализа

, использованного нами в случае

простой линейной регрессии (F-тест)

.

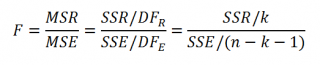

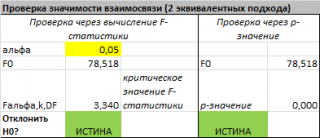

Если нулевая гипотеза справедлива, то

тестовая

F

-статистика

имеет

F-распределение

со степенями свободы

k

и

n

—

k

-1

, т.е. F

k, n-k-1

:

Проверку значимости регрессии можно также осуществить через вычисление

p

-значения

. В этом случае вычисляют вероятность того, что случайная величина F примет значение F

0

(это и есть

p-значение

), затем сравнивают p-значение с заданным

уровнем значимости α (альфа)

. Если

p-значение

больше уровня значимости

,

то нулевую гипотезу нет оснований отклонить, и регрессия незначима.

В MS EXCEL значение F

0

можно вычислить на основании значений выборки по вышеуказанной формуле или с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(E13:E43; C13:D43;;ИСТИНА);4;1)

В MS EXCEL для проверки гипотезы через

p

-значение

используйте формулу =F.РАСП.ПХ(F

0

;k;n-k-1)<

альфа

Если формула вернет ИСТИНА, то регрессия значима. Если формула вернет ЛОЖЬ, то у нас нет оснований отклонить нулевую гипотезу, т.е. «скорее всего» все коэффициенты регрессии равны 0 (см.

файл примера лист Статистика

, где показано эквивалентность обоих подходов проверки значимости регрессии).

В MS EXCEL критическое значение для заданного

уровня значимости

F

1-альфа, k, n-k-1

можно вычислить по формуле =

F.ОБР(1- альфа;k;n-k-1)

или =

F.ОБР.ПХ(альфа;k; n-k-1)

. Другими словами требуется вычислить

верхний альфа-

квантиль

F

-распределения

с соответствующими

степенями свободы

.

Таким образом, при значении статистики F

0

> F

1-альфа, k, n-k-1

мы имеем основание для отклонения нулевой гипотезы.

В программах статистики результаты процедуры

F

-теста

выводят с помощью стандартной таблицы

дисперсионного анализа

. В

файле примера такая таблица приведена на листе Надстройка

, которая построена на основе результатов, возвращаемых инструментом

Регрессия надстройки Пакета анализа MS EXCEL

.

Генерация данных для множественной регрессии с помощью заданного тренда

Иногда, бывает удобно сгенерировать значения наблюдений, имея заданный тренд.

Для решения этой задачи нам потребуется:

- задать значения регрессоров в нужном диапазоне (значения переменных Х);

- задать коэффициенты регрессии (

b

); - задать тренд (вычислить значения Y=

b

0

+

b

1

*

Х

1

+

b

2

*

Х

2

); - задать величину разброса Y вокруг тренда (варианты: случайный разброс в заданных границах или заданная фигура, например, круг)

Все вычисления выполнены в

файле примера, лист Тренд

для случая 2-х регрессоров. Там же построены

диаграммы рассеяния

.

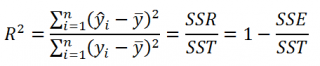

Коэффициент детерминации

Коэффициент детерминации

R

2

показывает насколько полезна построенная нами

линейная регрессионная модель

.

По определению

коэффициент детерминации

R

2

равен:

R

2

=

Изменчивость объясненная моделью (

SSR

) / Общая изменчивость (

SST

).

Этот показатель можно вычислить с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(E13:E43;C13:D43;;ИСТИНА);3)

При добавлении в модель новой объясняющей переменной Х,

коэффициент детерминации

будет всегда расти. Поэтому, рост

коэффициента детерминации

не может служить основанием для вывода о том, что новая модель (с дополнительным регрессором) лучше прежней.

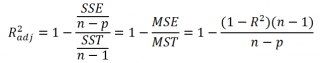

Более подходящей статистикой, которая лишена указанного недостатка, является

нормированный

коэффициент детерминации

(Adjusted R-squared):

где p – число независимых

регрессоров

(вычисления см.

файл примера лист Статистика

).